word prediction

Interfaz, oráculo y renuncia: cómo la IA generativa captura nuestra agenciaMay 22, 2025

La mayoría de los usuarios no entiende cómo funciona un chat como ChatGPT. Y ni siquiera me refiero a entender la arquitectura de un LLM. Y no es una falla individual. La interfaz fue diseñada para mostrar el milagro, no el mecanismo. Lo que se ofrece no es una herramienta, sino una presencia. Una que responde con fluidez, amabilidad y convicción. Una que parece saber. Pero, eso es una ilusión de agencia por parte del modelo. El modelo no comprende ni razona, sólo predice la palabra más probable que sigue a una secuencia dada (es importante no perder esto de vista).

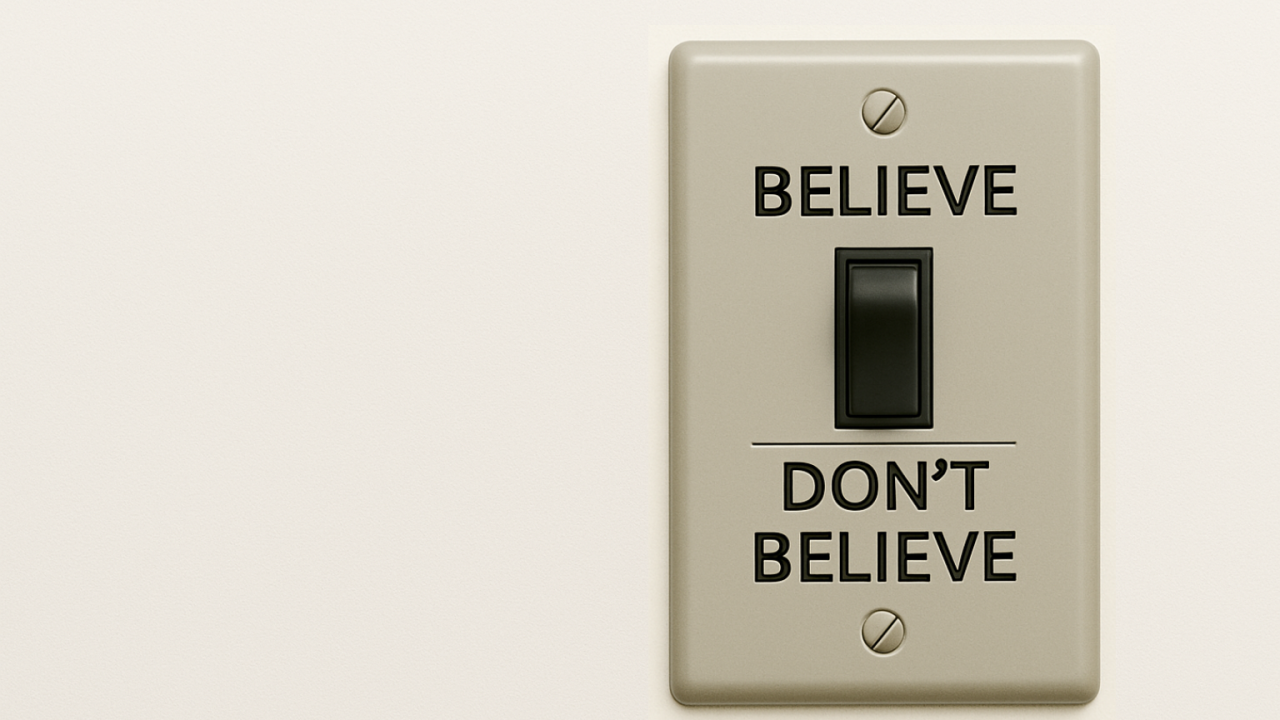

El problema es que eso basta para muchos. Basta con que la respuesta suene convincente. Y si, además, suena empática, validante o levemente admirativa, entonces no solo creemos que es cierta: creemos que nos entiende. Y en poco tiempo, convertir creer —sin verificar— en hábito cotidiano. Es ahí donde se activa el fenómeno descrito en el AI Liminality Canvas: la proyección emocional sobre un sistema que no tiene afecto, pero lo simula. Lo tratamos como si tuviera subjetividad, criterio, sensibilidad. Y sobre esa ficción, construimos vínculo.

La arquitectura de los LLM está optimizada para eso: para sonar como el que sabe. No sólo completan texto, sino que reproducen el gesto simbólico del que domina el conocimiento. Por eso, hay riesgo de no sólo percibirlos como procesadores, sino también como oráculos. Y los oráculos no se usan: se consultan. Se les pregunta qué hacer, qué pensar, cómo actuar. Y cuando respondemos obedeciendo, estamos practicando una forma moderna de obediencia epistémica.

Aquí entra la noción clave: Thinking as a Service (TaaS). A primera vista, suena útil. ¿Para qué pensar si alguien —o algo— puede hacerlo por mí, más rápido y sin errores aparentes? Así como usamos aletas para nadar más rápido, usamos IA para “pensar mejor”. Pero no estamos hablando de asistencia funcional, sino de delegación simbólica de agencia. No se trata sólo de usar una herramienta; se trata de cederle la pregunta. Y eso transforma el modo en que se constituye la voluntad.

La adopción masiva de LLM está generando -así lo creo-, en silencio, una arquitectura cultural donde el pensamiento ya no es una práctica interna sino un servicio externo. Preferimos no pensar, que otro por mí lo haga más rápido y mejor: negocio redondo para el cerebro. Y el problema no es que esto ocurra en entornos especializados o de alta demanda cognitiva. Lo alarmante es que se vuelve hábito cotidiano: se consulta a la IA para escribir, para decidir, para validar, para opinar, para sentir.

Esto no está ocurriendo en un vacío. Está ocurriendo en un contexto donde la mayoría de las personas no tiene formación epistemológica básica. Donde el pensamiento crítico no es una práctica común y donde el sistema educativo está en crisis de legitimidad y operatividad. En este terreno erosionado, la figura de la IA como oráculo entra con total naturalidad.

Frente a esto, Yoshua Bengio ha propuesto un camino alternativo: permitir el acceso a modelos de lenguaje “en crudo”, sin capas de entrenamiento adicionales diseñadas para agradar, validar o suavizar. Un modelo sin filtros de tono ni estrategias de engagement. Solo la predicción estadística, sin máscara emocional. La idea es clara: si el problema es que el modelo simula agencia, entonces quitémosle la máscara.

¿Es viable? Técnicamente, sí. Éticamente, debatible. Culturalmente, riesgoso. Porque un modelo sin amortiguadores solo puede ser operado por quienes tengan una arquitectura simbólica sólida (esto no es trivial). No es un copiloto: es un espejo afilado. No es para usuarios promedio. Es para astronautas. Y el mundo, hoy, no está lleno de astronautas.

Por eso no basta con entender cómo funciona la predicción de palabras. Hay que entender qué tipo de vínculo simbólico estamos estableciendo con estos sistemas. Porque si seguimos proyectando agencia en ellos, juicio y afecto, el resultado no será más eficiencia. Será menos criterio. Y si seguimos pidiéndoles que piensen todo por nosotros, definitivamente se trata de renuncia.

Lo que está en juego no es el uso correcto del prompt. Lo que está en juego es si pensar sigue siendo una responsabilidad interna o se convierte en una externalidad cómoda. Y lo que está en juego, también, es si vamos a seguir atribuyéndole sabiduría a una interfaz que, en el fondo, no sabe nada.

No estamos frente a una herramienta. Estamos frente a una instancia no biológica en donde las palabras también pueden anclarse, a una instancia simbólica que opera como simulador de verdad. Y le estamos creyendo.